Lineární regrese

Regrese se naučíme v poslední 11. lekci R pro základní kurz.

Jednoduchá lineární regrese

Pokud jsme schopni určit, která proměnná je závislá (značíme ji obvykle Y nebo Lhs od “left hand side”) na které nezávislé proměnné (značíme ji obvykle X nebo Rhs od “right hand side”), pak hovoříme o regresi (máme-li jen dvě takové proměnné, pak o regresi Y na X) – předchozí kovariance a korelace byly o vzájemných vazbách, ne závislosti. V regresi však nemusí jít nutně o závislost, ale často jde o snahu vysvětlit variabilitou proměnné X variabilitu Y při vědomí toho, že Y nemusí být přímo explicitně na X kauzálně závislá. Často tedy regresi používáme k vysvětlení variability jedné proměnné nějakou jinou proměnnou jinou o níž víme, že patří do skupiny proměnných, na níž první proměnná závisí. Nejjednodušším případem regrese je hledání lineární závislosti jedné vysvětlované proměnné na jedné vysvětlující proměnné.

Princip uvažování je podobný jako u ANOVA (jedná se o metodu, která patří do stejné skupiny metod označovaných jako obecné lineární modely). K nejdůležitějším bodům patří:

- data musí mít poměrový charakter s normálním rozdělením

- podstatou je získání takové lineární funkce, že pro každé měřené X je součet čtverců rozdílů (reziduí) mezi měřeným Y a Y, získaným z této funkce, minimální

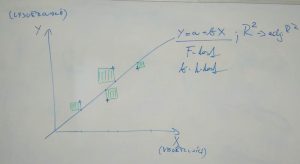

- výsledkem regrese je tak především funkce přímky, která prochází mrakem bodů XY grafu, kterou lze zapsat jako Y= a +bX, “a” je pak průsečík přímky s osou Y (= intercept) a “b” je směrnice udávající sklon přímky

- statistická významnost modelu se testuje pomocí F testu, který je analogií F-testu v ANOVA, jde tedy o test průměrných čtverců regrese a reziduí (F = MSreg / MSe), kde se průměrné čtverce (stejně jako v ANOVA) počítají jako podíl součtu příslušných čtverců rozdílů od průměru (SSreg = SUMA (reziduum Y – průměr Y)2; (SSe = SUMA (Y – reziduum Y)2) a počtů stupňů volnosti (dfreg = 1; dfe = n-2)

- dále se testuje rozdílnost parametru “b” od nuly, protože, kdyby byl roven nule, pak Y nezávisí na X (rovnice by pak měla vzorec Y = a) – používá se t-testu, kde v čitateli je hodnota “b” a ve jmenovateli střední chyba b

- významným ukazatelem je pak hodnota koeficientu determinance (R2), který udává procento vysvětlené variability vysvětlované proměnné hodnotami vysvětlující proměnné a počítá se jako SSreg / (SSreg + SSe)

- Příklad z přírodních věd 1: Z videí u korelací můžeme jako příklad vzít snahu o vysvětlení druhové bohatosti hodnotami pH podzemní vody.

- Příklad z přírodních věd 2: Existuje závislost biomasy samců na velikosti samice ostrorepa, která tyto samce nese při rozmnožování? Použijte soubor korelace.xlsx a proměnné samci_biomasa a samice_hmotnost.

- Příklad ze sociálních věd: Jaká je závislost ochoty návštěvníka zámku doporučit jeho návštěvu známým (měřené na 7-stupňové škále) na jeho spokojenosti s návštěvou (měřené na 7-stupňové škále).

Videoprezentace

Výpočet v MS Excel je jednoduchý a je nahrán na videu.

Mnohonásobná lineární regrese

Obvykle nezávislých proměnných měříme více a hledáme takovou proměnnou nebo takovou kombinaci proměnných, která statisticky významně vysvětlí závislou proměnnou. Do modelu vstupuje vždy větší počet vysvětlujících proměnných než jedna – identifikujeme tak větší počet koeficientů b (ke každé nezávislé proměnné). Odlišnost koeficientu b od nuly se testuje jako v jednoduché regresi t-testem. Stejně tak celkový model se testuje F-testem. Pro odhad vysvětlené variability se na místo koeficientu determinance (R2) používá upraveného koeficientu determinance – adjusted R2 (uvádí např Lepš, 1996, Vz. 14-7, kde m je počet nezávislých proměnných). Je třeba si uvědomit, že výsledek analýzy se bude lišit podle kombinace použitých vstupních nezávislých proměnných.

Výsledek mnohonásobné regrese je vždy třeba posoudit regresní diagnostikou v níž se posuzují data, model a metoda odhadu. Cílem je získat co nejjednodušší a přitom co nejpřesnější a statisticky významný model. Regresi tak opakujeme několikrát, vždy po úpravách složek diagnostiky – především se jedná o úpravy v datech (odstraňování odlehlých hodnot měření) a zařazování proměnných (= jejich výběr). K tomu jsou určeny statistické programy. S ohledem na výpočtové procedury je nutné dodržet pravidla pro mnohonásobnou lineární regresi – zejména normalitu dat jako u jednoduché lineární regrese a dále zabránění multikolinearitě (tedy vzájemné závislosti dvou a více nezávislých proměnných) a heteroskedascititě (tedy závislosti variance na hodnotě proměnné – provádí se Durbin-Watson testem, což je test autokorelace reziduálů, návod je kupříkladu na externím odkazu). Outliery lze nejjednodušeji identifikovat pomocí reziduálů, stejně tak i heteroskedasticitu. U odstraňování outlierů dávejte pozor – je vhodné se podívat, co za měření přesně odstraňuji a zvážit proč nesedí na model (jejich odstraňování zpochybňuje sběr dat). Multikolinearita je jedním s nejčastějších problémů a také asi nejtěžším problémem mnohonásobných regresí. Pokud multikolinearita existuje, pak obvykle regresní model vykazuje statisticky významný F-test, vyšší hodnoty koeficientu determinance, ale hodnoty b se t-testem neliší průkazně od nuly. Taktéž minimální změny v datech vedou ke zcela odlišným modelům, ty jsou tedy vysoce nespolehlivé. Dalším identifikátorem, že v modelu hraje roli multikolinearita, jsou vysoké hodnoty střední chyby odhadu. Obecně platí, že multikolinearitu nelze testovat, jen měřit. Kromě výše uvedených indicií se používá jednoduchých a vícenásobných korelačních koeficientů nezávislých proměnných. Hodnoty velmi blízké +1 a -1 mohou znamenat kolinearitu, ale nemusejí, proto by se vždy měl použít některý z dalších nástrojů měření – je jich velké množství k nejjednodušším patří Scottovo testační kritérium M

M1(2, . . .m) = (F/(1/m*SUMA(j=1)m (tj2)) – 1) / (F/(1/m*SUMA(j=1)m (tj2)) + 1)

kde F = hodna F statistiky regrese, t = hodnota t-statistiky všech regresních koeficientů s výjimkou interceptu (a), j = číslo pořadí nezávislého faktoru a m = počet nezávislých faktorů. Pak hodnota větší než 0,8 indikuje silnou multikolinearitu, od 0,33 do 0,8 mírnou kolinearitu

Dále se používá Variance Inflation Factor – zapotřebí je připravit inverzní korelační matici a hodnoty na diagonále (kde byly původně jedničky) vyšší než 10 indikují, že daná proměnná je lineární kombinací jiných proměnných. Odstranit ji lze vypuštěním “nadbytečných” proměnných – rozhodování je obtížné, navíc víme-li, že mezi nezávislými a závislou proměnnou existuje větší počet “kauzálních ” vazeb. Vypuštěním proměnné často dostaneme model, který nebude ve finále správný. Řešit to můžeme použitím jiné metody než je metoda nejmenších čtverců.

Vzhledem k tomu, že cílem je obvykle sestavit co nejjednodušší model, lze některé měřené proměnné z modelu vyřadit – buď ručně porovnáním dílčích regresních modelů nebo automaticky. Já používám proceduru krokového dopředného výběru, kdy jsou do modelu zařazovány postupně proměnné, které vysvětlují největší podíl variability nevysvětlené do modelu už zařazenými vysvětlujícími proměnnými (Forward Stepwise Selection).

Pro používání mnohonásobné lineární regrese je nutné nastudovat větší množství literatury – je to poměrně komplikovaná záležitost – externí odkazy např. tady, tady, tady, nebo tady.

Pokud nejsou splněny předpoklady pro použití lineární regrese, lze data nejprve transformovat nebo použít nelineární regrese, to vše ale je už za hranicemi základní statistiky a je mu věnován prostor v rozšiřující statistice.

- Příklad z přírodních věd: Identifikace závislosti pokryvnosti Drosera rotundifolia na chemických vlastnostech podzemní vody – měřeny byly: amoniakální dusík, dusičnanový dusík, celkový fosfor, vápník, železo, a sírany. Kvůli multikolinearitě byly některé měřené vlastnosti z analýzy vypuštěny.

Videoprezentace

Mnohonásobnou lineární regresi lze provádět přes Analytické nástroje i v MS Excel – je to stejný modul, jako v případě jednoduché lineární regrese, jen zadáte větší počet nezávislých proměnných. Ve výsledcích se lze dostat i v něm k tabulkám reziduí, grafům a parciálním regresním koeficientům. Základní postup zadání je na videu. Pokud byste potřebovali více informací, tak ty jsou kupříkladu volně dostupné na externím odkazu.

S ohledem na další možnosti nastavení budeme v rozšiřujícím studiu k řešení mnohonásobné lineární regrese používat software Statistica. Výpočet příkladu ve Statistica na videu.

Hodnoty b* jsou standardizovanými hodnotami parciálních regresních koeficientů a udávají tak “relativní význam” proměnné v rámci celého modelu, pro konstrukci rovnice musím použít koeficienty b (bez hvězdičky).

Řešení předchozího příkladu ve Statistice s využitím Forward Stepwise Selection je na videu.